Tipps & Tricks sowie Artikel zum Thema Database Security

Inhalt :

- Unified Auditing Oracle 12c in Practice Teil 4 (new 14.06.2016 )

- Unified Auditing Oracle 12c in Practice Teil 3 ( 09.03.2016 )

- Unified Auditing Oracle 12c Teil 2 (update 10.01.2016 )

Unified Auditing Oracle 12c Teil 1 (update 26.11.2015 )

Mutmaßlich flächendeckende Wirtschaftsspionage in Deutschland

Wirtschaftsspionage und Datenbanken

Innentäter

Über die Sinnhaftigkeit von Regelauswertungen für einzelne Datenbankstatements

Warum kaum in Database Security investiert wird

Database Activity Monitoring - Hightech im Namen - das reicht !

Resolving Oracle Objects oder wie Oracle über 30 Jahre lang Stolpersteine pflegt

Secure PL/SQL Code - dynamic vs. static

- Internes JDBC Gateway Oracle ( Oracle intern + MS SQLSERVER Query )

Internes JDBC Gateway als Security Feature

- Auditing sysoperation und personalisierte High Privileged Accounts

Massendaten mit dem Oracle ERRORTRIGGER vermeiden

- LISTENER.LOG auslesen mit PL/SQL

DBMS_LOB und die Quantenmechanik

- Verteidigungsschild mit Oracle System Triggern am Beispiel DDL/DCL

- Sqlplus prüft Statements nach Shutdown immediate

- openACC mit GCC oder accULL

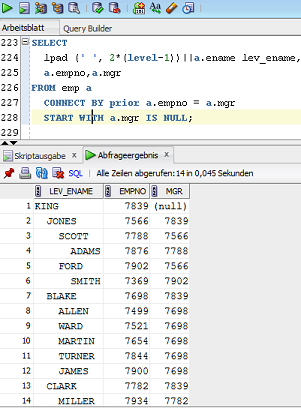

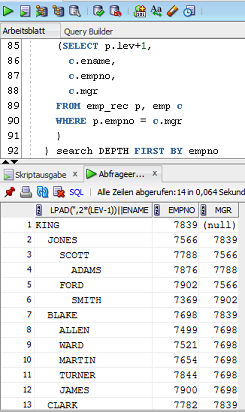

- 'CONNECT BY PRIOR' und 'WITH' Sortierung

- LEAD/LAG und ROW_NUMBER(), ein starkes Team

- LISTAGG Ersatz

- Privilegien unter Oracle - Schluß mit dem Eiertanz

BBS Pseudo Random Sequence Generator in Java

E-Mail Verschlüsselung und Dateiverschlüsselung für Anfänger Teil 1

Multilevel secure database encryption with subkeys

- Ist Oracle 12c durch SHA-2 angreifbar ?

- Sichere Erzeugung von Schlüsseln und deren Speicherort

- Oracle DB Security - Top 30

- Komplexität der Oracle Passwörter 10g / 11g

- Eingabe des Passworts und Abhängigkeiten vom Zeichensatz

- Remote OS Authentification

- Hash Funktionen DES und SHA-1 + Salt

- Unbekannte und unmögliche Passwörter

- Externe SHA-1 Verfizierung

- Passwort merken, wenn es 12 Stellen und mehr hat

- Oracle User Profiles

- Oracle Password Verification Function

- Oracle DES Hashes entfernen

- Erstmal keine Rechte - ein ungewohnter Ansatz für mehr Datensicherheit

- Forensik - Anzeichen für Datenmissbrauch

- Forensik - Top 5

- No SQL Injection

- Secure PL/SQL Programming ( updated 25.03.2013)

- Massivst Parallel - Performance unter Oracle

- SYS_GUID() als Default Function spart bis zu zwei Trigger

- Die

Macht der Virtual Columns

- Sqlplus / as sysdba ausschalten

- Data Treasures oder warum verschlüsseln nur bedingt hilft

- Der Versuch einer sicheren Datenbank über Open Source

Einleitung

Sie hören

immer öfter von SQL-Injection, DDL-Injection und weiteren teils

fortgeschrittenen Techniken um Angriffe gegen Datenbanken umzusetzen ?

Unser Eindruck ist, das der Rummel um diese realen Bedrohungen oft von den

eigentlichen Hausaufgaben im Bereich Datensicherheit ablenken.

Wir möchten Sie nicht verängstigen, sondern sensibilisieren.

Sie werden hier nicht den Tipp finden, wie man sich im Fall Oracle remote als

sysdba anmeldet, ohne das Passwort von sys zu kennen, oder wie man im

Datenbankblock die Verpointerung der originalen Sys.user$ auf eine eigene

xxx.user$ umbiegt.

Vielleicht gibt es diese Hintertüren ja überhaupt nicht, oder sie sind derart

aufwendig und komplex, das die Wahrscheinlichkeit der Ausnutzung sehr gering

sind.

Ausgehend von dem Begriff Hausaufgaben der mit Abstand

wichtigste Punkt : Passworte !

_________________________________________________________________________________________________________

Unified Auditing Oracle 12c in Practice Teil 4 (new 14.06.2016 )

Konzerndatenbanken sollten ein Basis Audit Policy Set besitzen, sowie eine Auditdatentransportlösung zum SIEM.

12c Datenbanken sollten minimal folgende Anteile/Messagetypen enthalten:

- 11g Basisset + neue kritische Privs/Actions/Roles sofern diese überhaupt mit Standardmitteln auditierbar sind!

- LOGON FAILED

- LOGON SUCCESS als Trigger

- ERROR als Trigger

- RMAN

- AUDIT

- EINIGE FIXED TABLES- nur auf Session Ebene!

- SYSCONTEXT

- DATAPUMP

- DIRECTLOAD

- RAS/RAC

LOGON SUCCESS muss nicht unbedingt als AUDIT POLICY abgebildet werden.

Die erweiterten Informationen des SYS.USER$ (LCOUNT, LAST_LOGIN, ... )

sind den Aufwand eines Triggers wert.

Beim Errortrigger sieht die Hauptbegründung etwas anders aus.

Zentrale Erfassung aller nicht abgefangenen Execeptions und kein Audit Policy Wust.

Aus einem 11g Basisset mit ca. 40 Audit Items werden so schnell 200 Items.

Dies hängt auch damit zusammen, das Oracle alle Auditmessagetypen außer den bekannten

Privs und Actions erstmals überhaupt über Unified Auditing auditierbar implementiert.

LOGON FAILED/SUCCESS, DIRECTLOAD uns DATAPUMP sind hierfür gute Beispiele.

Der DDL/DCL Trigger kann übrigens deutlich leichtgewichtiger über eine oder wenige Audit Policies abgebildet werden.

Die Datenbank arbeitet dann besonders bei Installationen deutlich flotter!

Jetzt beginnt der Tanz.

Je nach Auslegung der expliziten Audit Policies, minimal Session oder gar auf Statementebene, der möglichen Unterscheidung von

PDB'S sowie der grundsätzlichen Aktivierung entweder als erfolgreich oder als nicht erfolgreich, kommen selbst bei minimalistischer Auslegung allerhand Auditdaten in kürzester Zeit zusammen.

Die zusätzlichen möglichen Conditions in einer Audit Policy wurden in der vom Autor entworfenen Lösung nicht angewendet. Hier gilt es den Laufzeitbremseffekt dem Nutzen gegenüberzustellen.Prinzipiell sind diese Conditions einfach Filter die Datenmengen reduzieren können.

Zusätzlich kommt bei einer internen Auditdatentransportlösung (PL/SQL) z.B. im Push Verfahren ein kleiner Overhead für den Selbstschutz dieser Anwendung hinzu.

Das Problem ist die Sonderlocke, die sich hinter der View UNIFIED_AUDIT_TRAIL verbirgt. Ein Tabellenkonstrukt, vermutlich ein Secure File Derivat, das streng genommen überhaupt nicht beschreibbar ist, dafür jedoch weitgehenden Schutz vor Manipulationen der üblichen Art liefert.

Jeder Zugriff auf die Unified_Audit_Trail bei Counts > 100.000 kann schon wehtun. Ab 1 Mio Auditdatensätze wird es irreal.

Es gibt keine Chance der Zugriffsoptierung. Wenn auch noch CLOB Felder wie 'sql_text' in einer Auditdatentransportlösung mitübertragen werden, bekommt man zusätzlich schnell Schwierigkeiten mit dem PGA Memory wenn nicht allerhand Vorsorge bei der Programmierung diesbezüglich getroffen wird.

Um es mal einfach auszudrücken, Unified Auditing ist für folgende Einsatzzwecke konzipiert.

Wenig Audit Policies, noch weniger Audit Items und idealerweise alles nach dem Transport löschen.

Realistisch ist solch ein Szenario nicht. Allein die Löschlogik würde zudem Lücken im Auditdatenstream zulassen.

So nicht!

Will man hingegen die Auditdaten zyklisch in Tranchen (event_timestamp von-bis) versenden, wird es schnell teuer.

Eine Möglichkeit wäre eine recht hohe Frequenz eines Auditdatenjobs, der versucht die Auditdatenmenge generell recht klein zu halten.

Versuchen kann man es, doch was passiert, wenn z.B. hinterlegte Passwörter für den Datenbank Connect nicht vollständig geändert wurden. Zyklische Connect's von Agent's, Monitoren usw. erzeugen in kürzester Zeit hohe Auditdatenmengen.

Optionale Vorhaltepuffer, die z.B. den DBA's nun weitgehend unbedenklich Informationen über die letzten 24 Stunden geben ohne gelöscht zu werden treiben die Größe des Unified_Audit_Trail tendenziell in die Höhe.

Die Manipulation der Auditdaten ist auf Lowlevel Ebene zwar denkbar, doch kann dies mit Plausibilitätsprüfungrn und Checksummen als Bestandteil des Transportmechanismus, vergleichsweise einfach im SIEM erkannt werden.

Die Ablage der Checksummen muss natürlich selbst überwacht werden.

Im Sinne einer minimalen Gesamtbelastung, sollte die Auditdatentransportlösung zudem weitgehend von 'breiten' Zwischentabellen im Sinne der Verdichtung sowie komplexen internen Jobläufen befreit sein.

Alles unter einen Hut zu bringen fordert schon etwas Einsatz, den gewiss jeder nicht treiben will.

Fazit:

Aus Sicht des Autors ist das Unified Auditing in der aktuellen Form (12.1.0.2) operativ als Konzernlösung praktisch nicht einsetzbar.

Es ist möglich, doch der Aufwand und die Komplexität sprengt den üblichen Rahmen einer operativen Security Lösung.

Oracle sollte hier dringenst nach bessern.

1.a) Normale evtl. Partitioned Tables ohne update,delete,merge,truncate, drop

1.b) Extern abgelegte und geschützte Tabelle im Filesystem

2.) Clob Marker <= 32k und > 32K

2.) PK für UNIFIED_AUDIT_TRAIL

3.) Purge auf Basis beliebiger Ausdrücke/Spalten

4.) Vorhaltepuffer per DBMS_AUDIT_MGMT über Stunden und Anzahl einstellbar.

5.) Aggregationstemplates vor der Ablage im Unified_Audit_Trail

6.) 'Translate any SQL' und 'Inherit any Privilege' sollten auditierbar sein.

Kommentar :

Wenn Oracle ein Pseudo Feature namens Unified Auditing entwickelt hätte und es eigentlich um Audit Vault Lizenzen gehen sollte, wäre dies schon nicht mehr dreist sondern unverfroren.

Wer seine Datenbank schützen will muss ordentlich bezahlen, sei es mit ASO bzw. mit Audit Vault, usw.. Eine Regelung die nicht nur vielen Agencies in die Hände spielt.

Das die Probleme mit dem PGA Speicher erstmals mit der Version 12c massiv auftreten hat hoffentlich nichts mit

der In-Memory Option und deren Verkauf zu tun.

In diesem Sinn ein P(r)ost-greSQL auf freie Software.

Am 5.7.16 spricht übrigens Richard Stallmann in Frankfurt/Main.

Unified Auditing Oracle 12c in Practice Teil 3 ( 09.03.2016 )

Herleitung der Aussage :

Die Auditierung von Oracle Datenbanken ist flächendeckend machbar bei akzeptablen Kosten für die Datenbank.

Pure Unified Auditing ist die Konfiguration bzw. Zielkonfiguration vieler 12c Datenbanken.

Was sollte man beachten, wenn man eine Transportlösung von Auditdaten, konkret Auditmessages, in Richtung SIEM entwickelt ?

Die Gliederung der Audit Policies sollte minimal über die Audittypes welche Oracle vorgibt, erfolgen.

- Standard

- FineGrainedAudit

- XS

- Database Vault

- Label Security

- RMAN_AUDIT

- Datapump

- Direct path API

Eigene Audittypes könnten z.B. LOGON SUCCESSFUL und LOGON FAILED sein.

Letzterer ist sinnvollerweise durch eine Audit Policy abbildbar.

Die interessanten Informationen hingegen erhält man über den Audittype LOGON SUCCESSFUL, der über

einen AFTER LOGON Trigger abgebildet werden sollte.

Wenn man nun für jeden seiner Messagetypen ein eigenes Format entwickelt, erzeugt das allerhand Aufwand im SIEM.

Alle Informationen statisch in ein Messageformat abzubilden kann man, muss es aber nicht.

Key/Value benötigt generell mindestens eine Umformung.

Besser ist folgender Aufbau: Header, Standard Payload und erweiterte Payload, die auf die jeweiligen Audittypen abgestimmt sind.

Rein auf Performance darf man hier nicht optimieren. Man muss den bitteren Fakt miteinbeziehen, das Datenbank Security Know How erst sehr spät in der Kette der Auswertungs- Bewertungs- Prozesse vorhanden sein wird und dies in nicht mal 1% aller Fälle.

Daher sind die Vorbereitungsarbeiten bezgl. Auditmessages wie die Gliederung, das Messageformat und mögliche Vorbewertungen von besonderer Bedeutung.

Das Thema Vorbewertung wird oft ohne trifftiges Argument von der SIEM Auswertungsseite kategorisch abgelehnt.

Der Autor hält dies für nicht sinnvoll. Mitunter bekommt man den Verdacht, das lizenzrechtliche Gründe von bestimmten SIEM Produkten eine Rolle bei dem Thema spielen. Stichwort : Datenvolumina. Wer etwas vor der Versendung filtert, aggregiert und/oder vorbewertet, wird im Schnitt weniger Daten an ein SIEM versenden als Systeme die dies nicht tun.Zudem können Auswertungs und Bewertungsprozesse hinter dem SIEM optimiert werden.Dies im Sinne der Datensicherheit und der eingesetzten Manpower.

Der Knackpunkt liegt in der Erkennung von reinen Datenbankangriffen, wenn es soetwas überhaupt gibt, bzw. in der Vorbewertung eines Sicherheitsvorfalls.

Beispiel : 'grant dba to public'. Ohne Zweifel in nahezu allen Datenbanken außer denjenigen der Kommune 69, ein schwerer Sicherheitsvorfall.

Wie kommt es zu solch einem Statement ?

Entweder war es ein Spielkind, ein Anteuscher der den eigentlichen Angriff über einen anderen Weg überdecken will, oder vielleicht ein Pentester.

Der DDL/DCL Trigger führt sein Revoke sofort aus und alle Daten bezgl. 'grant dba ...' werden mit einem sehr hohen Kritikalitätsfaktor an das SIEM versendet.

Hier wird sogar aktiv eingegriffen. Noch so ein Thema, bei dem die 'Gelehrten' gerne in Wallung kommen.

Das Beispiel mit 'grant dba to public' dürfte in heutigen Zeiten nahezu überall ein 'no go' sein. Bis die Auswertungs- und Bewertungs- Prozesse nach üblichem Ablauf den Revoke Befehl bei einem Security DBA in Auftrag geben, kann je nach

Effektivität des Gesamtablaufs eine gehörige Zeit mit den sozialistischen DBA Rechten vergangen sein.

Datenstrukturen :

Oracle hat das Unified_Audit_Trail deutlich breiter ausgelegt im Vergleich zur klassischen sys.aud$.

Trotz der vielen Attribute in der View Unified_Audit_Trail gibt es Auditszenarien, die höchst individuelle Informationen benötigen.

Warum Oracle hier keine asynchrone Anreicherung der Unified Auditing Daten anbietet, ist unverständlich.

Der Vorschlag lautet :

Audit Policies schreiben mit Bedingungen in einer Flagdatenstruktur. Wenn dort mehrere Flags für einen potentiellen Sicherheitsvorfall eintrudeln, die einer definierten Granularität entsprechen, wird asynchron eine frei definierte PL/SQL Procedure/Function ausgeführt, welche die zusätzlichen Daten in eine per referenzieller Integrität verknüpften Subtabelle der Unified_Audit_Trail schreibt.

z.B. via Key/Value. Den Zeitpunkt für diese Ausführung entscheidet die 'schlaue Datenbankversion 12c' selbst.

Da es soetwas derzeit noch nicht gibt, muss man ggfs. auf Database Trigger bzw. auf die 'sys_events' Architektur zurückgreifen.

Drei Database Trigger stehen bei Härtungen praktisch immer zur Diskussion.

- LOGON

- ERROR

- DDL/DCL

Der Logon Trigger ist ein After LOGON Trigger und damit die Variante Successful.

Neben der LoginTime, LastLoginTime, den CountFailedLogins können noch etliche weitere Informationen über den betrffenden Acount via sys.user$ und sys.dba_users ermittelt werden.

Der Trigger macht Sinn gerade im Vergleich zu einer Audit Policy auch wenn er bei den ganzen Informationsermittlungen Kosten verursacht. Eine Filtertabelle, welche festgelegte Loginvorgänge aus dem Triggercontext herausfiltert, sollte zur Absicherung gegen Massendaten implementiert werden. Ein Monitoringccount, der sich alle paar Sekunden einloggt, könnte ansonsten die Datenmengen ohne Aggregation gewaltig in die Höhe treiben.

Der After Error Trigger ist ein spezieller Kandidat.

Kann er doch die nicht behandelten Exceptions Ihrer Software unbarmherzig ans Tageslicht befördern.

Diese können gerade bei Kaufsoftware und je nach Release, extrem große Datenmengen ohne Aggregation erzeugen.

Diesen Anteil sollte man zyklisch mitlaufen lassen jedoch nicht generell bzw. im Aggregationsmodus. Wenn man seine Pappenheimer kennt, sind temporäre Filter durchaus zulässig.

Ein zweiter Anteil sind diejenigen Errors, die typischerweise mit Exploits bzw. deren Vorbereitung erzeugt werden können.

Dieser Anteil sollte generell mitlaufen. Wie man die beiden Anteile unterscheidet ist kein Hexenwerk dafür harte Arbeit.

Der DDL/DCL Trigger sollte nur sehr rudimentär oder überhaupt nicht verwendet werden.

Ein vergleichbare Audit Policy mit den wichtigsten DCL und DDL Actions/Privs kostet um den Faktor 30 weniger.

Gefährliche Grants wie z.B. "grant dba to public" würde ich mit einer aktiven Revoke Gegenmaßnahme im Trigger belassen.

Damit der Name Unified Auditing seinen Namen verdient, kann man etwas nachhelfen. Falls Database Trigger verwendet werden, können die Daten über eine simple Audit Bypass Policy von der Triggertabelle in das Unified Audit Trail umgeleitet werden, ohne das in die Triggertabellen geschrieben wird! Default dort "Rollback" statt "Commit Write".

Bleibt die Implementierung der eigentlichen Versendung von Auditdaten.Direkt oder mit Zwischenschritten.

Empfohlen wird das Push Verfahren und die direkte Versendung.

Hier steht die Lastverteilung im Vordergrund.

Das ist kein Gimmick sondern das zentrale Akzeptanzfeature für die Einführung von flächendeckendem Auditdatentransport.

Ohne eine ausgefuchste Lastverteilung werden viele Datenbanken nur äußerst rudimentär oder überhaupt nicht auditiert.

Die Lastverteilung sollte parametrierbar sein z.B. über eigene Application Context Key/Value Paare.

Was ist in einem solchen Sektion alles zu tun ?

Wir haben z.B. Messageviews die auf der Unified_Audit_Trail aufsetzen.

Wir haben zumindest bei Spalte 'SQL_TEXT' ein Clob, welches eine Aufteilung der Messages in teilweise recht viele Einzelmessages durchführt und wir haben eine Versendelogik vielleicht einen TCP/IP Socket.

All dies performant mit dem speziellen Tabellentyp der Basistabellen der Unified Audit Trail abzubilden ist selbst für einen alten Hasen allerhand Aufwand.

Die Tabelle Unified_Audit_Trail verhält sich bezgl. Performance nicht wie eine gewöhnliche Tabelle ohne Indizes.

Spätestens ab 50.000 Datensätzen wird jeder Zugriff auf das Unified Audit Trail äußerst kostenintensiv.

Daraus folgt, das man eine lastverteilende Logik entwickeln sollte, die ein Anwachsen des Unified Audit über einen definierten Schwellwert für maximal einen Tranchenlauf erlaubt.

Teuer sind vor allen die Bestimmungen von Timestamps, die für den Purge des Unified Audit Trail zwangsweise durch Oracle Vorgaben notwendig sind.

So ein Timestamp im Unified Audit Trail ist nicht eindeutig. Das gilt ebenso in Verbinding mit der Entry_id und der Instance_id.

Gelöscht wird, wenn das Package DBMS_AUDIT_MGNT dazu aufgelegt ist in der Logik ' echt kleiner' bzw. 'echt älter'.

Bis 12.1.0.1 ist der Purge absolute Glückssache bei Größen bis zu 1500 Datensätzen.

Ab 12.1.0.2 wurde dies im Schnitt auf etwa 800 Datensätze reduziert.

Konkret bedeutet das, das wenn z.B. 10000 Datensätze per Purge entfernt werden sollen, das bis zu 1500 / 800 Datensätze je nach DB Version nicht entfernt werden.

Dafür ist die fehlerhafte Purge Prozedur schnell. Vermutlich wird asynchron im Hintergrund gelöscht. Dies muss allerdings

erst noch nachgewiesen werden.

Wer jetzt noch einen Vorhaltebuffer mit einer Anzahl von jüngsten Datensätzen konkurrierend in Stunden und einem absolutem Wert angibt, der kann die Auditdaten zwar versenden, entfernt werden sollten diese Daten aus den unterschiedlichsten Gründen jedoch nicht.

Meist ist so ein Vorhaltepuffer ein Zugeständnis an die DBA Truppe. Diese hat i.d.R. gute Gründe, die jüngsten Auditdaten z.B. des letzten Tages direkt einsehen zu können. Natürlich besteht ein Restrisiko das DBA Fehler oder DBA Angriffe aus dem Unified_Audit_Trail herausgelöscht werden könnten. Dies würde allerdings zu Lücken im Unified_Audit_Trail führen.Daher sollten

nicht alle zyklischen Aktionen gegen die DB über die Filterlogik herausgefiltert werden. Kontrollaggregate können einen Nachweis

für den regulären Betrieb ohne Eingriffe liefern.

Weiterhin ist die fehlerhafte Purge Funktion des Package DBMS_AUDIT_MGMT eine weitere Abschreckung.

Insgesamt steht der Autor auch hier auf der pragmatischen Seite. Die Vorteile des Vorhaltebuffers für den Gesamtbetrieb wiegen stärker als das beschriebene Restrisiko. Sicherheit beinhaltet auch die Begriffe Stabilität und Konsistenz.

Die Lastverteilung erfolgt z.B. über Parameter wie : max. Messages / Tranchenlauf (5000) und dies alle 5 Minuten im Zeitraum

19:00-5:00

Wenn man diese ganzen Fälle performante implementiert hat und die Lastverteilung funktioniert, steht einer Einführung der

Transportlösung nichts mehr im Wege.

Codierungsrichtlinien und Test

Die performante Implementierung ist ein Paradebeispiel für die bedingte Gültigkeit von den vielen klugen Ratschlägen, wie ein PL/SQL Programm aussehen sollte. Bei mir kam jedenfalls eine sehr kompakte

Procedure heraus. Diese hat allerdings eine Komplexität mit mindestens dem Faktor 5 -10 gegenüber der 'Vorschrift'.

Dafür arbeitet sie recht flott und fast alle potentiellen Fehler sind in ca. 200 Zeilen zu finden.

Noch dazu ist das Gesamtprojekt bezgl. Code auf eine Person aktiv + 1 Person Review ausgelegt.

Selbst in einem 80 Personen Projekt würde ich diese Prozedur verteidigen.

Wer sich die Mär von einer gleichmäßig verteilten Komplexität ausgedacht hat, weiss ich nicht.

Wenn es Komplexitätspeaks gibt, kann das Vereinfachungen im Rest des Quellcodes bedeuten.

Beide Aspekte vereinfachen das Testen vom Gesamtaufwand her wesentlich.

Lieber in 50 x 200 Zeilen 95 % der Fehler nachweisen als in z.B. 200.000 Lines of Code einen gleichmäßig, umfassenden und insgesamt gigantischen Testaufwand betreiben.

Testen wurde in 1980er/1990er Jahren gerne unterbewertet. Heute würde ich sagen: Es wird teilweise übertrieben.

Absicherung des Transportmechanismus

Wichtigste Regel : Push Verfahren

Wer etwas nachdenkt, wird eine einfache Maßnahme entdecken, welche die Unversehrheit des Transportmechanismus ohne künstliche Datensendungen zu jedem Laufzeitpunkt sicherstellt. Die Gesamtheit der Datensendungen kann im SIEM einfach überprüft werden.

Die Absicherung der Auditdaten gegen Manipulation sowie die Absicherung der Metadaten des Transportmechanismus gegen Manipulationen ist nach meiner Meinung mit Abstand der komplexeste Teil des Gesamtprojekts. Als kleiner Wink sei die das Wort Audit genannt.

Eigene Designfehler oder auch nicht:

Anfänglich hatte ich wunderschöne Parallel Pipelined Tablefunctions entworfen. Einmal um die Messages aufzusplitten und einmal für die Versendung. Die jeweiligen 'dicken Cursor' Ausdrücke hatten allerdings ihren Preis.

Die Parameter PGA_AGGREGATE_LIMIT der 12c musste auf 10GB hochgezogen werden um Fehlermeldungen beim Parallelisierungsgrad 8 zu vermeiden.

Ein typischer Copy/Paste Fehler, der allerdings durch die Tatsache entsteht, das die Hints in Oracle unglücklicherweise mit Remarks verwechselt werden können.

Wenn Tablefunction A mit dem Parallelisierungsgrad 8 einen Cursor mit dem Aufruf einer weiteren Tablefunction B ebenfalls mit dem Parallelisierunggrad 8 erhält, dann laufen bis zu 64 Prozesse!

Wer jedoch seine Auditdaten in einem kleinen Zeitfenster ohne ein Limit von Kosten verarbeiten will, kann sich dieses Ansatzes annehmen.

Quasi der Turbo mit Ladedruck 2,0 bar, solange der spannungsfreie Motorblock dies mitmacht.

Interessant ist, das selbst Socketkommunikation per Parallel Query sauber parallelisiert werden kann, wenn man einige Regeln befolgt.

Diese Regeln sind allerdings Betriebsgeheimnis ...

Unzulänglichkeiten von Oracle im Kontext Unified Auditing:

Bis 12.1.0.1 kein Audit auf Fixed Tables in PDB's möglich.

Setter Audit's der RAS Policy ebenfalls bis 12.1.0.1 PDB's nicht möglich.

Fehler beim Purge bis mindestend 12.1.0.2. Einige Datensätze werden zu 90% nicht gelöscht.

Purge nur auf Timestamp Basis ist nicht sinnvoll. Alternativ über ID von / bis

Index Ermöglichung auf Basistabellen der Unified_Audit_Trail.

Erweiterung der Conditions von Audit Policies mit Aufruf eigener Procedures/Functions zur Datenanreicherung.

Ein Mini API basierend auf sys_events bzw. komplett individuell. Ergebnisse in eine Key/Value Audittabellle.

Gesamtperformance:

Was kostet weniger : Ein SUV mit 3 to Realfahrgewicht und 300PS oder ein Mittelklassewagen mit 1,4 to und 150PS ?

Der SUV ist die Datenbankversion 12c im Pure Unified Auditing Mode. Viele neue Funktionen der 12c verlangen zwangsläufig nach einer Auditierung. Die gefährlichsten neuen Funktionen lassen sich zudem mit dem den neuen Allheilmittel Unified Auditung überhaupt nicht auditieren.

Das Ergebnis einer einzelnen Audit Policy kann günstiger sein als das Ergebnis der klassischen Audit Statements Pendants, muss es aber nicht. Die Auswertungszeit ist zwar nicht günstiger, jedoch die Datenmengen können deutlich reduziert sein.Insgesamt kann dies ein Vorteil bedeuten, jedoch nur bei einer sorgsamen Balance von Bedingungen in Audit Policies und deren Nutzen in Bezug auf Datenreduktion bzw. in Bezug auf den Gesamtablauf z.B. Vorbewertung.

Die Gesamtbelastung der Auswertungen einer 12c liegt bei einer hinreichend* bemessenen Härtung jedoch höher als bei hinreichend bemessenen Härtung der Version 11g. Die Tricks der Queued Write für das Unified Audit Trail kann einiges von dieser Gesamtbelastung wettmachen. Dies allerdings zu Lasten der Gesamtsicherheit. Cached Auditing Data. Darauf muss man ersteinmal kommen.

In jedem Fall ist das Löschen der Auditdaten in der Datenbank 12c deutlich effizienter als die schnellste Commit Point orientierte Löschroutine z.B. der sys.aud$.

Mit dem Mixed Mode könnte man übrigens tatsächlich etwas Gesamtbelastung einsparen, allein durch sys_operations=true.

Die Übernahme der Aud-Files in das Unified_Audit_Trail ist das eigentliche Killerfeature des Mixed-Mode.

Fazit : Unified Auditing und auch Pure Unified Auditing ist ein Schritt in die richtige Richtung. Es sollte weiterentwickelt werden.

Die Datenbankversion 12c abzusichern erfordert deutlich mehr Aufwand im Policy Design im Vergleich zur Version 11g.

Das Policy Design kann je nach Händchen ein Gewinn sein oder ein Schuß in das berühmte Knie werden. Der Schlüssel sind wenige optimierte Bedingungen mit einem hohen durchschnittlichen Nutzwert.

Die Zwänge die Oracle dem Unified Auditin auferlegt und damit die Security Fraktion in ein sehr starres Korsett zwingt, sollten überdacht werden. Den Denkansatz das Auditing als Nicht DBA Task nahezu durchgängig abzubilden soll dennoch ausdrücklich gelobt werden. Der Teufel steckt allerdings wie immer im Detail.

Die Auditierbarkeit von DataPump, DirectLoad, RMAN, AUDIT, SYS CONTEXT sowie RAS, teilweise nicht abschaltbar, ist aus Sicht der Datenbanksicherheit ein echter Gewinn.

Mit solchen Auditdaten werden Sie nicht nur vielen illegalen Datenabziehern auf die Schliche kommen.

* hinreichend in dem Sinn: Machbarkeit mit den Mitteln des Unified Auditing.

z.B. 'Translate Any Sql' und 'Inherit Any Privileges' erfordern erhebliche individuelle Zusatzmaßnahmen um diese überhaupt auditierbar zu machen.

Unified Auditing Oracle 12c Teil 2 (new 10.01.2016 )

Mit dem Artikel von Uwe Hesse über den Performance Impact von Unified Auditing fühlte sich der Autor an die Zeiten der Oracle 7,8,9 Vorführungen erinnert, die mit teils undokumentierten Caching-Parametern, die jeweilige Datenbankversion als regelechten Turbo auswiesen. Damals wurden vor den Vorführungen alle relevanten Tabellen für einen bestimmten Use Case in den Memory geladen, der Transaction und Write Overhead deaktiviert und der Tanker Oracle wurde zum Porsche Turbo.

http://uhesse.com/2015/07/31/less-performance-impact-with-unified-auditing-in-oracle-12c/

In dem Artikel wird eine einzelne Audit Policy erstellt die ein einzelnes Select auf eine Anwendertabelle auditiert.

Ein identisches Select Statement wird 100000 Mal aufeinander folgend ausgeführt um den Performance Impact zu messen.

Ob die Auswertung von 100000 Select's die unterschiedlich ausfallen sich bezgl. Performance Impact anders darstellen, erfahren wir nicht.

Gemessen wird:

Auswertung Audit Policy mit Erkennung 100000 identischer Statements + Write Overhead in eine 'Read only Table'.

Wenn man den Performance Impact bzgl. Auditing von 11c und 12c vergleichen will, sollte man einges bedenken:

Ein direkter Vergleich von Audit 11g mit Create Policy - Audit 12c, macht nur bei vergleichbarem Security Level Sinn.

In jedem Fall sollte der Security Level einer Oracle 12c nicht niedriger als der einer 11g sein.

Da ein 11g Audit immer Immediate Write und ohne Caching in der SGA abgearbeitet wird, ist der Vergleich mit der Unified Auditing Einstellung

EXECUTE DBMS_AUDIT_MGMT.SET_AUDIT_TRAIL_PROPERTY

(

...

=> DBMS_AUDIT_MGMT.AUDIT_TRAIL_IMMEDIATE_WRITE);

durchzuführen.

Vergleicht man 11g Audit mit 12c Queued Audit Write vergleicht man Äpfel mit Birnen.

Das Caching von Auditdatensätzen ist deswegen gefährlich, weil Angriffe genau aus diesem Grund mit Forcierungen von ORA-600 Fehlern, wenn nicht gar dem vollständigem Stillstand der Oracle Datenbank abgeschlossen werden könnten.

Dies kann neben dem Sinn der Verschleierung des Angriffs zusätzliche kostenintensive Schäden verursachen.

Der Vorteil für die Angreifer besteht darin, das diese mit Zero Day Exploits arbeiten können, die wahrscheinlich nicht nachvollzogen werden können. Die Methoden zur Forcierung von Ora-600 Fehlern und Stillstand der gesamten DB sind offenbar nur sehr bedingt bei den bekannten Security Researchern bekannt.Entweder entwickeln diese wenig oder sie nutzen nicht die gesamten Funktionalität der Datenbank aus.

Wenn man nun 11g Auditing mit 12c Pure Unified Auditing Audit Write Immediate vergleicht, macht es weiterhin wenig Sinn eine einzelne Auditpolicy für ein Select Statement zu erstellen und dieses identische Select in einem Loop 100000 Mal durchlaufen zu lassen.

Das ist praxisfremd und wirkt ein wenig hingetrickst auf die Nutzung von mehrstufigen Caches der Oracle DB mit dem gewünschten Nachweis, das Unified Auditing weniger Performance Impact verursachen (muss).

Etwas eindimensional. Warum?

- Erstens nur eine Policy.

- Zweitens eine optimierte Erkennung von identischen Statements im Memory der 12c im Gegensatz zu 11g.

- Drittens die Queued Write Audit Einstellung, zumindest in dem Artikel von Uwe Hesse.

Realistischer ist da schon folgender Vergleich:

1.) Ein komplettes 11g Audit Set z.b. ein Hardening Audit Set mit seiner Abbildung via Audit Policies in 12c Pure Unified Auditing

2.) Dies vorerst im Non-Multitenant(Single Instance) Mode der 12c, der mittlerweile deprecated ist.

3.) Jeweils mit der identischen Einstellung in Bezug auf 'force logging' auf Datenbankebene.

Mit Force Logging kann auch bei 12c mit Pure Unfified Auditing sys_operations=true ergebnistechnisch erzwungen werden.

Auch wenn der MOS-Artikel bekannt ist, läuft sicher nicht jede Oracle Datenbank in diesem Modus.

https://oraculix.wordpress.com/2009/06/18/risiken-bei-der-verwendung-von-nologging/

Hat man das Audit Set Hardening Basic mit z.B. 30-40 Audit Statements in einer 11g flach abgebildet, gibt es bei dessen Abbildung

über Audit Policies unzählige Varianten, die entscheidend für die Performance sein können.

Die einen schreiben soviele Actions und Privs wie möglich in eine oder wenige Audit Policies.

Andere strukturieren gerne und enden mit einer Anzahl von vielleicht 5 oder 15 Audit Policies.

Fängt man an bestimmte unnötige Auditdateneinträge des 11g Audit Sets über mehr oder minder

komplizierte Bedingungen der Audit Policy Syntax der 12c herauszufiltern, oder versucht Redundanzen akribisch mit Bedingungen zu eleminieren, kann dies zu einem deutlichen Performance Impact

führen. Nicht zwangsläufig durch eine Audit Policy jedoch in einer Gesamtbetrachtung realistischer Einsatzszenarien.

Mit den Conditions wird u.a. ein Werkzeug geliefert um die Datenmengen zu kontrollieren. Dies wird allerdings an einer recht ungeschickten Stelle mit allerhand Kosten erkauft. Besser sind Postffilter / Postaggregations.

Mit diesem Mttel lassen sich auch Redundanzen herausfiltern.

Zsätzlich kommen noch neue Privs und Actions der 12c hinzu, die in einem Basic Hardening nicht fehlen sollten.Diese neuen Privs und Actions sind teilweise nicht über Unified Auditing auditierbar. Der Aufwand dies doch zu realsieren kostet einiges.

Wenn man schon den Performance Impact von Unified Auditing in den Fokus stellt, das darf man die Zwangsmaßnahmen von

Oracle nicht vergessen.

Diese sind, auch wenn sinnvoll, gleich ob Pure oder Mixed Mode, implizite, nicht vorinstallierte Audit Policies,

die folgende Actions bzw. Privs auditieren und nicht deaktivierbar sind und die Datenbank nicht gerade schneller machen.

RMAN Operations

CREATE AUDIT POLICY

ALTER AUDIT POLICY

DROP AUDIT POLICY

AUDIT

NOAUDIT

EXECUTE of the DBMS_FGA PL/SQL package

EXECUTE of the DBMS_AUDIT_MGMT PL/SQL package

ALTER TABLE attempts on the AUDSYS audit trail table (remember that this table cannot be altered)

Top level statements by the administrative users SYS, SYSDBA, SYSOPER, SYSASM, SYSBACKUP, SYSDG, and SYSKM, until the database opens. When the database opens, Oracle Database audits these users using the audit configurations in the system—not just the ones that were applied using the BY clause in the AUDIT statement, for example, but those that were applied for all users when AUDIT statement does not have a BY clause or when the EXCEPT clause was used and these users were not excluded.

All configuration changes that are made to Oracle Database Vault

In dem erwähnten Artikel von Uwe Hesse wird übrigens ein wenig vorschnell auf sysdba Auditierung geschlossen und der Eindruck erweckt diese wären lückenlos.

Audit könnte den einen Teil erklären. Top level Statements von SYS, SYSDBA, SYSOPER, SYSASM, SYSBACKUP, SYSDG, and SYSKM den anderen.Alterativ RMAN. Oder 'force logging'.

Jetzt kommen noch einige neue Features des Unified Auditing:

Actions Components wie Datapump und Direct Load sowie Application Context Parameter waren bislang nicht direkt auditierbar, machen jedoch Sinn.

Hinzu kommem minimal die beiden Oracle Audit Policies für RAC Systeme.

Schlußendlich noch das Thema sys_operations=true, das eigentlich in jedem Hardening Konzept bis 11g eine wichtige Rolle einnimmt und lückenlos sein sollte. Selbst wenn dies die Auditierung von ellenlangen SQL-Scripten beinhaltet.

Dies kann in einer 12c mit den Mitteln des Pure Unified Auditing nur über die Datenbankeinstellung 'force logging' erreicht werden.

Ohne force logging wird es mühsam alle sys operations samt Fehler zu auditieren.

Ohne einen System Database Trigger After Error wird es gewiss nicht gehen.

Nun kommt die ersten Stufe der Transformationen des Vegleichs.

12c Singletenant:

Hier funktionieren einige Audit Policies z.B. auf Fixed Tables nicht.

Gleiches gilt für 12c Multitentant, zumindest für die PDB's.

Nun zum Löschen

Wer ein truncate in einem laufenden operativen System auf sys.aud$ absetzt, hat das Auditing im Sinn seiner Bedeutung nicht verstanden.

In einem Hardenung/Audit Konzept wird für gewöhnlich partiell gelöscht und zwar zeit und/oder mengenorientiert.

Die Gründe liegen nah. Performance Impact ( Verteilung über die Zeit) und festgelegte Verfügbarkeit jüngerer Auditdatensätze für Analysen. Dies ist zweifelos einer der teuersten Punkte der 11g Implementierung.

Man kann zwar über Delete direkt mengenorintiert löschen, doch ist die sys.aud$, egal in welchem Tablespace sie sich befindet,

eine normale Tabelle im read-write Mode.

Hier hat das Unified Auditing mit den Fixed Table ähnlichen CLI... Tables einen deutlichen Performancevorteil.

Der Nachteil besteht jedoch in der eindimensionalen Purge Logik, die ausschließlich über das Packages DBMS_MGMNT erfolgen muss. Löschen via Delete ist jedenfalls nicht möglich.

Die Löschungen erfolgen entweder full oder bis zu einem vorher gesetzten Zeitstempel.

Mengenlöschungen abhängig von der Gesamtzahl der Auditdateneinträge im Unified Audit Trail sind nur mit teuren Count Operationen zu erkaufen und machen den eigentlichen Performancevorteil der Purge Routine schnell zunichte.

Folgende Löschregel ist nicht ungewöhnlich : Wenn die Anzahl der Auditdatensätze die maximal einen Tag alt sind, z.B. kleiner als 100.001 ist, dann lösche alles das älter als ein Tag ist.

Hier nochmals die Anteile einer minimalen Härtung aus Sicht des Auditing für 12c Pure Unified Auditing:

- Transform your 11g Hardening Audit Set to 12c via Create Audit Policy - if possible!

- New Privs /Actions 12c via Create Audit Policy

- Action Components

- Audit Application Contexts

- optional RAC/RAS Policies

- New Privs/Actions via Eigenbau, weil nicht direkt auditierbar!

Risiken bzgl. höherem Performance Impact 12g:

- Formulierung der Audit Policies - Anzahl

- Formulierung der Audit Policies - Bedingungen

- Formulierung der Audit Policies - Teilersatz für sys_operations =true wenn DB nicht im ' force logging' Mode

- Formulierung der Audit Policies - ohne Bedingungen - Datenredundanz

- Eigenbau für nicht direkt auditierbare Privs/Actions!

- Implizite Audit Policies von Oracle erzwungen

- Datenbank im 'force logging' Mode statt Punkt 3

Die Anteile einer minimalen Härtung aus Sicht des Auditing für 11g:

Einstellungen: DB,extended, sys_operations=true

- Hardening Audit Set via Audit

Fazit :

Wichtig ist dem Autor die Gesamtbetrachtung von Security und Performance in einem operativen System das zumindest ein Basic Hardening besitzt und einen wie auch immer abgebildeten Transportmechanismus für Auditdaten zum SIEM besitzt.

Eine einzelne Audit Policy als Indikator für den Performance Impact zu verwenden ist einfach unseriös.

Es gilt die Gesamtbelastung des Auditing inkl. Transport ( Push Verfahren ) zu ermitteln und im Konzernumfeld sind Möglichkeiten der Verteilung dieser Gesamtbelastung zusätzlich von großer Bedeutung auch wenn diese die Gesamtbelastung erhöhen.

Macht es bei bestimmten Datenbanken Sinn, teure Operationen des Auditing inkl. Transport über 24 Stunden möglichst gleich zu verteilen, gibt es andere Datenbanken, die in bestimmten Zeitfenstern größere Belastungen klaglos verkraften.

Wenn man ein Hardening bzw. Auditing Konzept zwischen 11g und 12c Pure Unified Auditing vergleicht, kann allein der

Geschwindigkeitsvorteil bei Erstellung der Aud Files / XML oder der Abtransport über syslog, besser syslog-ng, in der Gesamtbelastung für das Datenbanksystem den Performance Sieger 11g ergeben. In Audfiles zu schreiben ist weniger Ressourcenbelastend, selbst im Vergleich zu einer optimierten CLI... Table in einem Read ähnlichen Mode und direkt via syslog erst recht. Ist es da nun? Nein.

Sieht man es weniger dogmatisch und nutzt den Mixed Mode der 12c, ist nach Ansicht des Autors der Sieger in Bezug auf Security und Performance Impact eindeutig die 12c. Man kann die Vorteile beider Auditimplementierungen nutzen und so die

jeweiligen Präferenzen für Security und Performance genau in dieser Reihenfolge abbilden.

Wer den Einsatz von Auditing vorrangig vom Performance Impact abhängig macht, arbeitet letztendlich für Nachrichtendienste oder für die Konkurrenz!

Unified Auditing Oracle 12c (update 26.11.2015 )

Die neuen Möglichkeiten des Unified Auditing sind interessant, wirken jedoch leider nicht zu Ende gedacht, geschweige denn umgesetzt.

Das soll wohl auch so sein wie die erweiterten Audit Events der kostenpflichtigen AUDIT VAULT Option anschaulich dokumentieren.

Soll Unified Auditing nun ein vollständiger exklusiver Ersatz für alle bisherigen Auditoptionen sein oder nicht ?

Eher nicht, wie Oracle selbst dokumentiert.

You cannot audit the following system privileges:

- SYSASM,

- SYSBACKUP,

- SYSDBA,

- SYSDG,

- SYSKM,

- SYSOPER,

- TRANSLATE ANY SQL

- INHERIT ANY PRIVILEGES,

Die Admin Privilegien mit hunderten von Einzelprivilegien lassen sich schon mal nicht auditieren.

Zwei neue und nicht unkritische Funktionalitäten lassen sich ebenfalls nicht audititieren, jedenfalls nicht im Sinne von USE.

Audit insert, update, delete on sys.aud$ by access;

funktioniert dies bei der/den Tabellen hinter der View Unified_Audit_Trail in beiden Fällen nicht.

Die Audittabelle des Unified Auditing ist ja auch vom Typ Read-Only, jedenfalls für fast alle.

Weiterhin sind die altbekannten SQL-Shortcuts

- Audit role

- Audit profile

- Audit database link

nicht so über Audit Policies abbildbar, auch nicht wenn der Mixed Mode aktiv ist.

SQL-Shortcuts sind in diesem Kontext Gruppierungen von Privilegien.

Das bedeutet, man wird zu einer gewissen Geschwätzigkeit in der Formulierung der Policies gezwungen.

So kann man zwar jede dieser SQL-Shortcuts der alten Audit Statement Konvention in eine Audit Policy transformieren, doch verkehrt sich hier nicht nur der Parsing und Memory Overhead nach ersten Tests in einen Performancenachteil statt einem theoretischen Performancevorteil, es sein denn, man nutzt einen Cachingmechanismus der eine gewisse Anzahl von Auditdatensätzen puffert bevor diese in die Audittabelle geschrieben werden.

Ob das der Weisheit letzter Schluß ist, Auditdaten im Memory zu puffern, bezweifelt der Autor.

Auch dem Caching Effekt sind insgesamt Grenzen gesetzt wenn ab einem bestimmten Punkt die Auswertungslogik auf Lowlevel Ebene primär die CPU belastet und das Schreibproblem zweitrangig wird.

Ein Designfehler oder nur eine Frage des Umgangs ?

Pseudofeature für den Hochglanzprospekt oder in definierten Grenzen ein Fortschritt ?

Aus

Audit role;

wird mit Unified Auditing jedenfalls

CREATE AUDIT POLICY ka_role_2_4

ACTIONS

CREATE ROLE,

ALTER ROLE,

DROP ROLE,

SET ROLE;

Will man nun SYSDBA, SYSBACKUP, ... Privilegien mit Unified Auditing auditieren, bleibt einem ohne Mixed Mode nichts anderes übrig als ein Monster von Audit Policy Typ (viele) Actions zu schreiben, welche einige Hundert Privileges aus DBA_SYS_PRIVS ( DBA, SYS, <Roles>) via ACTIONS für alle Accounts mit eben SYSDBA, SYSBACKUP, ... protokolliert.

Da braucht es dann allein für diese eine Audit Policy einiges an Speicher.

Alternativ kann man gleich ACTIONS ALL für all diese Accounts als Audit Policy hinterlegen.

Für beide Varianten hat man zusätzlich die Pflege der Userlist an der Backe!

Oder man beläßt den Default Mixed Mode und sys_operations=true ist ab der Version 12c sogar die Default Einstellung.

Es drängt sich der Verdacht auf, das die Mixed Mode Default Einstellung die einzig sinnvolle Einstellung ist.

Warum ?

Viele kleine Audit Policies mit einem funktional begrenzten Laufstall klingen zwar gut, können aber durch die Auswertungsoverhead, hier jetzt auf Lowlevel Ebene, eine Datenbank gehörig belasten.

Zwei extreme und bewußt überzogene Ansätze :

Man schreibt viele feingranulare Audit Policies welche die aufkommende Auditdatenmenge die letztendlich in eine Audittabelle geschrieben werden muss, so gering wie möglich hält und zahlt dies mit teils komplexen Auswertungsregeln zur Laufzeit der Datenbank.

Oder man protokolliert vereinfacht gesagt nahezu alles mit und schreibt diese Massendaten ohne den Low-Level Auswertungsaufwand in die Tabelle. Anschließend filtert und aggregiert man die Massendaten bevor es Richtung SIEM geht.

Bei dem ersten Ansatz kommt man wie McAfee/Intel mit seinem Activity Monitoring Tool irgendwann immer in ein Zeitproblem.

Ein theoretisches Feature das an den Sportwagen mit 500 PS erinnert der durch hunderte von Sicherheitsfunktionen die Nennleistung praktisch nie auf die Straße bekommt und effektiv ein 200PS Auto mit 1,8 to ist.

Der zweite Ansatz muss bei den heutigen Techniken der SAN's mit Caches samt Virtualisierung nicht der Schlechteste sein.

Der Autor hätte sich eine eigene optionale Datenbankblockstruktur für Read Only Tabellen gewünscht, die den gesamten Transaktionsoverhead herausläßt.

Eine Partitioned Read-Only Tabelle bei der lediglich eine aktive Partition Parallel Stream orientierte Schreibvorgänge in eine extrem performante Datenbankblockstruktur zulässt. Dies natürlich nur für den Auditmechanismus.

Wenn man jetzt noch den Multitenant Ansatz hinzunimmt und man 90% seiner Auditpolicies auf CDB$ROOT verlagert und sich nicht in feingranularen Policies verliert, den Mixed Mode schön beläßt, kommt man einer sinnvollen Architektur ein wenig näher.

Die Frage stellt sich nun, warum es das Unified Auditing eigentlich gibt ?

Der Name sagt es. Es geht um die Vereinheitlichung der Datentöpfe in die Auditdaten geschrieben werden und das ist für sich betrachtet durchaus ein Fortschritt.

Die Audit Policies sind ein Beiwerk, quasi die Verpackung, von der sich natürlich alle ernsthaften Sicherheitsfachleute magisch angezogen fühlen.

Knackpunkt ist allerdings die einfache Übernahme der AUD Files in das Unified Audit Trail.

Diese Vereinheitlichung ist Gold wert. Das kann jeder nachvollziehen der sich über die Jahre mit den verschiedenen Formaten der

AUD Files samt Transaktionsverhalten (APPEND) näher beschäftigt hat.

Hat man den Mixed Mode aktiviert und stellt sicher, das sys_operations=true bleibt, werden

die AUD Files Inhalte in das UNIFIED AUDIT TRAIL mit

übertragen.Die erfolgreich übertragenen 'AUD' Files sollen anschließend implizit gelöscht werden. Letzteres kann der Autor auf der aktuellen Oracle Developer VM 12c leider nicht bestätigen. - November 2015EXEC DBMS_AUDIT_MGMT.LOAD_UNIFIED_AUDIT_FILES;

Sind nun alle Auditeinträge der AUD Files mit derart wenig Aufwand im Unified Audit Trail, können mit Filtern bzw. Aggregaten nicht nur diese Anteile der Auditdaten konsolidiert, sprich minimiert werden, bevor diese an das SIEM versendet werden.

Ein Balancing zwischen OLD Auditing und NEW Unified Auditing wird zudem ermöglicht, bevor die eine oder andere 12c Installation zu stark durch das Auditing insgesamt belastet wird.

Man bedenke, das umsichtige DBA's mit der 12c nicht direkt auf Multitenant gehen werden.

Dies ist allerdings nach ersten Tests für Unified Auditing die denkbar ungünstigste Variante aus Sicht der Last/Performance.

Wenn irgendwann Multitenant tatsächlich Einzug in die Firmen hält, ist ein Verlagerung des Auditing Overhead durch die

konsequente einheitliche Nutzung über CDB$ROOT möglich und verspricht tatsächlich eine deutliche Entlastung der PDB's.

Das alles heißt übersetzt : Nutzt den Mixed Mode und Ihre habt bis auf sys.aud$ eine Auditdatentabelle/View nämlich Unified Audit Trail. Idealerweise im Multitentant Mode mit mehr als einer PDB!

Falls Ihr ohne klassische Audit Statements auskommen könnt, gibt es keinen Aufwand zur die Pflege der sys.aud$ im Kontext SIEM.

Einen bedeutenden Nachteil hat allerdings auch der Mixed Mode:

Es existiert keine Querverbindungen zwischen beiden Auditmechanismen.

Etwas wie

CREATE AUDIT POLICY ka_role_classic_2_4

PRIVILEGES ROLE;CREATE AUDIT POLICY ka_role_classic_2_4

ACTIONS ALL FOR ROLE;

funktioniert leider nicht.

Sinngemäß wäre dies ein 'Audit Role' im Audit Policy Wrapper.

Neben dem erwähnten Performancevorteil wären die Auditdaten auch gleich im richtigen Topf, nämlich dem Unified Audit Trail.

Der Parser der Create Audit Policy Funktion ist übrigens ziemlich tolerant und erkennt mitunter nicht den eigentlichen Scope durch den nachgeschalteten Freischaltungsschritt. Andererseits lässt er Dinge durchgehen die nicht funktionieren.

CREATE AUDIT POLICY KA_AUD$_2_4

ACTIONS ALL ON SYS.AUD$;

AUDIT POLICY KA_AUD$_2_4;

Wenn wir schon bei Parsern sind und das Caching noch mit einbeziehen, kann folgender Test überraschende Ergebnisse liefern:

Eine Audit Policy wurde deaktiviert. Testschema ohne Reconnect im SQL-Developer mit Befehl der die nun deaktivierte Audit Policy betrifft.

Wer jemals Hot Cache Implementierungen geschrieben hat, erkennt in vielen Programmen eine Kraut und Rüben Architektur

nur durch die Nutzung derselben z.B. SQL Developer.

Von einem Unified Auditing hätte man eigentlich ein Package erwarten können, das Auditdaten aus PL/SQL und SQL in das Unified Audit Trail umleitet, doch dieses Manko kann, wie wir noch sehen werden, mit einem simplen Eingriff ausgeglichen werden.

Weiter mit dem Konzept von Unified Auditing

Schlimm wird es wenn bestimmte Privilegien überhaupt nicht auditierbar sind, oder um es genau zu formulieren:

Die Erkennung der Verwendung des Privilegs ist in potentiell vorhandenen Auditdatensätzen ohne Zusatzmaßnahmen nicht möglich.

Das gilt für z.B.

- INHERIT ANY PRIVILEGES,

- TRANSLATE ANY SQL

sowie für erzeugte Fehler durch 'sys as sysdba', 'sysbackup' usw.

Für die Fehler bleibt nur ein After Error Trigger auf Datenbankebene übrig.

Bei den beiden neuen Privilegien Inherit any Privileges und Translate any SQL ist es ohne eigene Compliance/Logik nur schwer möglich, die Nutzung zu erkennen und direkt auditieren kann man, wie Oracle selbst einräumt, diese nicht.

Oracle lernt bezgl. der Balance zwischen Funktionalität und Sicherheit offenbar nur sehr langsam.

Bei 'Inherit any Privileges' ist zudem der implizite Grant an Public zu überdenken.

Sicherer ist eine Whitelist von Trusted Usern.

Die eigentliche Nutzung des Privilegs ist damit aber auch nicht auditierbar.

Bei 'Translate any SQL' überkommt einen gar das Gefühl es mit einer eingebauten Backdoor zu tun zu haben.

Ein derart tief angesetzter Hook, der auch mit Audit Policies keinerlei Aufschluss über die Nutzung des Privilegs

gibt, ist schon heftig.

Für die beiden neuen Privilegien werden Lösungen zur Auditierung in einem eigenen Artikel erörtert.

Weiterhin sind in den Audit Policies keinerlei SYS EVENTS direkt abfragbar.

Ein entscheidender Nachteil.

Daraus folgt i.d.R die Nutzung von Triggern auf Datenbankebene.

DDL/DCL System Trigger auf Datenbankebene können bei der Auditierung unbedingt notwendig bis sinnvoll sein.

Rein protokollierend als Afer DDL/DCL Trigger oder blockierend als Before DDL/DCL Trigger.

Letztere Variante besitzt neben dem Protokollanteil eine aktive Komponente.

Wird die Security Compliance eingehalten geht der Befehl durch, ansonsten wird geblockt.

'Grant dba to hacker' könnte ein Beispiel sein oder die Erstellung von Usern,

die eines der hoffentlich 'ungefakten' Standardprofile zugeordnet bekommen müssen. Falls nicht, wird es diese User nie geben.

Oracle hat in der Datenbank 12c übrigens einen Grant Trigger auf Datenbankebene implementiert.

Mit solch einem Before Grant oder Before DDL/DCL Trigger könnte man übrigens vielen Exploits der Showtruppe, die aus einigen Researchern besteht, einfach einen Riegel vorschieben. Diese Leute könnten sich dann endlich den weniger spektakulären Angriffen aus dem regulär privilegierten Umfeld widmen. Genau diese Angriffe aus dem Innern von regulären Usern, dürften nach Schätzung des Autors den Löwenanteil aller Angriffe aus Sicht der Kosten/Schäden ausmachen.

Ein After Error Systemtrigger auf Datenbankebene ist ebenfalls dringend zu empfehlen.

Man sieht damit welche Qualität Anwendungen hinsichtlich Exceptions besitzen und viele Angriffsmuster erzeugen Fehler

die i.d.R. nicht abgefangen werden.

Mit folgender Audit Policy könnte man formal den Errortrigger nachbauen:

AUDIT POLICY KA_SEC_ERRORS_1_3 ACTIONS ALL;

AUDIT POLICY KA_SEC_ERRORS_1_3 whenever not successful;

Wer jetzt meint, dies wäre identisch mit einem After Error Systemtrigger, der irrt.

Versuchen Sie mal einen Fehler als 'sys as sysdba' oder 'sysbackup' zu erzeugen und Sie werden diesen lediglich in der

Tabelle des After Error Systemtrigger finden und nicht im Unified_Audit_Trail.

Warum Oracle derart grundlegende Funktionaltäten aus dem neuen Auditing ausblendet, ist vielfach interpretierbar.

Gerade DBA's stehen bedingt durch die Privilegienfülle, berechtigt oder nicht, praktisch immer im Fokus.

Klevere DBA's wünschen sich zumindest in Europa eine lückenlose Protokollierung ihrer Tätigkeiten damit sie jederzeit nachweisen können, das sie bei einem Sicherheitsvorfall eben nicht direkt aktiv waren. Mit dem Event-Actor Prinzip sollte dies in auch in Europa möglich sein. Indirekt beteiligt können DBA's zwar immer noch an Angriffen sein, doch dies ist eine andere Geschichte.

Bleibt wie oben schon erwähnt eben die Empfehlung eines After Error Trigger.

Dort hat man es allerdings wieder mit vergleichsweise großen Datenmengen zu tun und sollte das Thema Filter

evtl auch vor der Versendung an das SIEM näher beleuchten.

Ein After ( succesful) Logon Trigger ist für sich betrachtet durchaus über Audit Policies abbildbar.

Wenn man allerdings den Last Login Timestamp normaler User ermitteln möchte oder die bewußte

Nichtprotokollierung des Last login normaler User, kommt man um einen After Logon Trigger

nicht herum.Die lückenlosen Logins aller Admin User funktionieren natürlich auch mit einem After Logon Trigger.

Für den erfolglosen Login schreibt man dann noch eine Audit Policy.

Wenn man nun diverse SYS EVENTS samt zugehörigen Triggern einsetzt,

entsteht folgender Overhead im Scope Auditdatentransport zu einem SIEM :

- Jeder Trigger enthält nativ den PLSQL/JAVA Code und eben keine eigenen Prozedure Calls um Abhängigkeiten zu vermeiden.Vorsicht besonders beim After Logon Trigger!

- Jeder Trigger schreibt seine Erkenntnisse üblicherweise in eine (eigene) Tabelle.

- Jeder Trigger läuft durch diese DML Operation üblicherweise unter dem Pragma Autonomous.

- Im Exceptionhandler wird ein Rollback abgesetzt und zur Sicherheit ein Eintrag ins Alert.log

über sys.dbms_system.ksdwrt( 3, bla bla) geschrieben.

Nun entstehen so meist allerhand Tabellen und der individuelle Transport zum SIEM ( pro Tabelle ) und die anschließende Teillöschung der Tabellen muss geregelt werden.

Wie wäre es, diese Auditdaten der diversen Audit-Triggertabellen ins Unified Audit Trail umzuleiten.

Der Clou wäre, im Erfolgsfall den Auditdatensatz nicht redundant in die Triggertabelle zu schreiben.

Wenn das Schreiben ins das Unified Audit Trail nicht möglich ist, wird versucht zumindest in das Alert.log

zu schreiben.

So ein Trigger sieht etwa so aus:

Event : After Error

Scope : Database

Filter sind optional und werden dringend empfohlen.

create or replace TRIGGER secmon_after_error_trg

AFTER SERVERERROR ON DATABASE

--

-- Revision $_KA_D

--

DECLARE

PRAGMA AUTONOMOUS_TRANSACTION;

sql_text ORA_NAME_LIST_T;

v_stmt CLOB; -- SQL statement causing the problem

n NUMBER; -- number of junks for constructing the sql statement causing the error

v_program VARCHAR2(64);

v_serial number;

v_sid number;

v_stuck number;

v_flag number;

v_msg varchar2(32767);

cursor c1 is

select filter_logic, filter_regexp

from secmon.cfg_filter

where filter_object = 'ORAERROR'

order by filter_logic desc;

BEGIN

--

-- Skip everything in case of an archiver stuck

--

select count(*) into v_stuck from v_$archive_dest where destination is not null and status = 'ERROR';

IF (v_stuck > 0)

THEN

NULL;

ELSE

select program,serial#,sid into v_program,v_serial,v_sid from gv_$session where sid=sys_context('USERENV', 'SID');

n := ora_sql_txt(sql_text);

IF n >= 1

THEN

FOR i IN 1..n LOOP

v_stmt := v_stmt || sql_text(i);

END LOOP;

END IF;

for n in 1..ora_server_error_depth loop

-- default - all errors will be logged

v_flag := 0;

for irec in C1 loop

if irec.filter_logic = 'BLACK' then

if regexp_like(sys_context('USERENV','OS_USER') || '~' ||

sys_context('USERENV','SESSION_USER') || '~' ||

sys_context('USERENV','HOST') || '~' ||

sys_context('USERENV','TERMINAL') || '~' ||

v_program || '~' ||

sys_context('USERENV','IP_ADDRESS') || '~' ||

to_char(ora_server_error(n)), irec.filter_regexp, 'i')

then

v_flag := 1;

exit;

end if;

end if;

end loop;

if v_flag = 0 then

insert into secmon.oraerror

(

id,

log_date,

os_user,

session_user,

isdba,

instance_nr,

host,

terminal,

program,

client_ip,

serial#,

sid,

scn,

err_nr,

err_msg,

sql_text,

err_cnt,

err_min_log_date

) values

(

secmon.secerror_seq.nextval,

current_timestamp,

sys_context('USERENV','OS_USER'),

sys_context('USERENV','SESSION_USER'),

sys_context('USERENV','ISDBA'),

sys_context('USERENV','INSTANCE'),

sys_context('USERENV','HOST'),

sys_context('USERENV','TERMINAL'),

v_program,

sys_context('USERENV','IP_ADDRESS'),

v_serial,

v_sid,

sys.dbms_flashback.get_system_change_number(),

ora_server_error(n),

ora_server_error_msg(n),

v_stmt,

0,

NULL

);

end if;

end loop;

COMMIT WRITE BATCH NOWAIT;

end if;

EXCEPTION

WHEN others THEN

rollback;

sys.dbms_system.ksdwrt(3,'ORA-20100: DATABASE TRIGGER SECMON_AFTER_ERROR_TRG ERRROR !!!! '||SQLERRM );

END secmon_after_error_trg;

/

Mit ein paar kleinen Änderungen können wir die Daten in das Unfied Audit Trail umleiten.

Wir schreiben die Daten z.B. in Key/Value Manier in einen String.

v_msg := '';

v_msg := '#log_date='||current_timestamp||

'#os_user='||sys_context('USERENV','OS_USER')||

'#session_user='||sys_context('USERENV','SESSION_USER') ||

'#isdba='||sys_context('USERENV','ISDBA')||

'#instance_nr='||sys_context('USERENV','INSTANCE') ||

'#host='||sys_context('USERENV','HOST') ||

'#terminal='||sys_context('USERENV','TERMINAL')||

'#program='||v_program ||

'#client_ip='||sys_context('USERENV','IP_ADDRESS') ||

'#serial#='||v_serial ||

'#sid='|| v_sid ||

'#scn='|| sys.dbms_flashback.get_system_change_number()||

'#err_nr='||ora_server_error(n) ||

'#err_msg='||ora_server_error_msg(n) ||

'#sql_text='||v_stmt ||

'#err_cnt='||0 ||

'#err_min_log_date='||NULL;

Diesen String fügen wird in den Original Insert ein.

Die Stelle ist eigentlich egal. Wenn man Memory Exceptions miteinkalkuliert, dann vielleicht eher am Anfang.

Die Oracle DB ist in C/C++ geschrieben und PL/SQL ist eigentlich nur ein Wrapper.

...

if v_flag = 0 then

insert into secmon.oraerror

(

id,

log_date,

os_user,

session_user,

isdba,

instance_nr,

host,

terminal,

program,

client_ip,

serial#,

sid,

scn,

err_nr,

err_msg,

sql_text,

err_cnt,

err_min_log_date

) values

(

secmon.secerror_seq.nextval,

current_timestamp,

sys_context('USERENV','OS_USER'),

sys_context('USERENV','SESSION_USER'),

sys_context('USERENV','ISDBA'),

sys_context('USERENV','INSTANCE'),

sys_context('USERENV','HOST'),

sys_context('USERENV','TERMINAL'),

v_program,

sys_context('USERENV','IP_ADDRESS'),

v_serial,

v_sid,

sys.dbms_flashback.get_system_change_number(),

ora_server_error(n),

ora_server_error_msg(n),

v_msg||' END OF KEY VALUE#ORIGINAL SQL_TEXT='||v_stmt,

0,

NULL

);

end if;

...

Dann müssen wir noch den COMMIT WRITE BATCH NOWAIT direkt hinter dem Insert enfernen

und gegen ein Rollback austauschen.

rollback;

Der Knackpunkt kommt jetzt:

Wir schreiben eine Audit Policy für Insert Statements auf unsere Triggertabelle.

Create Audit Policy ka_audit_help_fcts_1_4

ACTIONS INSERT ON SECMON.ORAERROR;

Und aktivieren das gute Stück.

Audit Policy ka_audit_help_fcts_1_4

Ein Fehler provoziert man schnell:

Select * from ka.rally_cars;

ORA-904 ...

Was passiert jetzt :

Der Errortrigger springt an und setzt einen Insert Statement ab.

In dem Insert Statement wird an der Stelle SQL_Text der komplette Datensatz als Key/Value übergeben

inklusive dem SQL_TEXT der den Error verursachte.

Die Audit Policy springt an und protokolliert das Insert Statements auch wenn es im Normalfall mit Rollback

zurückgefahren wird.

Interessant ist, das für ein tatsächliches Schreiben bei Autonomen Transaktionen ein Commit notwendig ist.

Das Absetzen des Insert-Statements scheint hingegen für sich betrachtet schon hinreichend für die Auslösung der Audit Policy Events zu sein. Das Rollback kann dies nun auch nicht mehr ungeschehen machen.

Aus Sicherheitgründen ist die Protokollierung des Versuchs eines Inserts durchaus sinnvoll und zeigt uns die implizite Wirksamkeit der Beispiel Audit Policy, nämlich whenever successful + whenever not successful.

Da es sich hierbei intern um ein Bind Aktion handelt, sind die Daten im Feld SQL_BINDS des Unified Audit Trail direkt auslesbar.

Man kann dies als Nested Insert vorstellen.

Im Normalfall gibt es keinen Entrag in der Tabelle des After Error Trigger, eben durch die Rollback Anweisung.

Wenn es knallt, wird minimal ein Eintrag in das Alert.log geschrieben.

Dies könnte man dahingehend erweitern, als man prüft, ob der Key Value Sting valide ist, und diesen

ebenfalls in das Alert.log schreibt.

Letzter Schritt ist das Auslesen dieser Nested Auditdateneinträge (SQL_BINDS) und daraus logisch einen formalen Auditdatensatz bzw. eine Message gemäß Format für das SIEM zu erzeugen.

Kein Hexenwerk.

Damit hat man ein Muster, um ein umfassendes Unfied Auditing zu implementieren.

Abschließend könnte der Trigger dann etwa so aussehen :

create or replace TRIGGER secmon_after_error_trg

AFTER SERVERERROR ON DATABASE

--

-- Revision $_KA_D

--

DECLARE

PRAGMA AUTONOMOUS_TRANSACTION;

sql_text ORA_NAME_LIST_T;

v_stmt CLOB; -- SQL statement causing the problem

n NUMBER; -- number of junks for constructing the sql statement causing the error

v_program VARCHAR2(64);

v_serial number;

v_sid number;

v_stuck number;

v_flag number;

v_msg varchar2(32767);

cursor c1 is

select filter_logic, filter_regexp

from secmon.cfg_filter

where filter_object = 'ORAERROR'

order by filter_logic desc;

BEGIN

--

-- Skip everything in case of an archiver stuck

--

select count(*) into v_stuck from v_$archive_dest where destination is not null and status = 'ERROR';

IF (v_stuck > 0)

THEN

NULL;

ELSE

select program,serial#,sid into v_program,v_serial,v_sid from gv_$session where sid=sys_context('USERENV', 'SID');

n := ora_sql_txt(sql_text);

IF n >= 1

THEN

FOR i IN 1..n LOOP

v_stmt := v_stmt || sql_text(i);

END LOOP;

END IF;

for n in 1..ora_server_error_depth loop

-- default - all errors will be logged

v_flag := 0;

for irec in C1 loop

if irec.filter_logic = 'BLACK' then

if regexp_like(sys_context('USERENV','OS_USER') || '~' ||

sys_context('USERENV','SESSION_USER') || '~' ||

sys_context('USERENV','HOST') || '~' ||

sys_context('USERENV','TERMINAL') || '~' ||

v_program || '~' ||

sys_context('USERENV','IP_ADDRESS') || '~' ||

to_char(ora_server_error(n)), irec.filter_regexp, 'i')

then

v_flag := 1;

exit;

end if;

end if;

end loop;

v_msg := '';

v_msg := '#log_date='||current_timestamp||

'#os_user='||sys_context('USERENV','OS_USER')||

'#session_user='||sys_context('USERENV','SESSION_USER') ||

'#isdba='||sys_context('USERENV','ISDBA')||

'#instance_nr='||sys_context('USERENV','INSTANCE') ||

'#host='||sys_context('USERENV','HOST') ||

'#terminal='||sys_context('USERENV','TERMINAL')||

'#program='||v_program ||

'#client_ip='||sys_context('USERENV','IP_ADDRESS') ||

'#serial#='||v_serial ||

'#sid='|| v_sid ||

'#scn='|| sys.dbms_flashback.get_system_change_number()||

'#err_nr='||ora_server_error(n) ||

'#err_msg='||ora_server_error_msg(n) ||

'#sql_text='||v_stmt ||

'#err_cnt='||0 ||

'#err_min_log_date='||NULL;

if v_flag = 0 then

insert into secmon.oraerror

(

id,

log_date,

os_user,

session_user,

isdba,

instance_nr,

host,

terminal,

program,

client_ip,

serial#,

sid,

scn,

err_nr,

err_msg,

sql_text,

err_cnt,

err_min_log_date

) values

(

secmon.secerror_seq.nextval,

current_timestamp,

sys_context('USERENV','OS_USER'),

sys_context('USERENV','SESSION_USER'),

sys_context('USERENV','ISDBA'),

sys_context('USERENV','INSTANCE'),

sys_context('USERENV','HOST'),

sys_context('USERENV','TERMINAL'),

v_program,

sys_context('USERENV','IP_ADDRESS'),

v_serial,

v_sid,

sys.dbms_flashback.get_system_change_number(),

ora_server_error(n),

ora_server_error_msg(n),

v_msg||' END OF KEY VALUE#ORIGINAL SQL_TEXT='||v_stmt,

0,

NULL

);

end if;

end loop;

rollback;

end if;

EXCEPTION

WHEN others THEN

rollback;

sys.dbms_system.ksdwrt(3,'ORA-20100: DATABASE TRIGGER SECMON_AFTER_ERROR_TRG ERRROR !!!! '||SQLERRM||'#'||nvl(v_msg,'No Key/Value Data' );

END secmon_after_error_trg;

/

Den vollständigen Insert samt COMMIT in den Exception Handler zu kopieren, kann theoretisch Sinn machen.

Praktisch wird es, wenn es knallt, zu mindestens 90% an der Triggertabelle liegen. Wenn das Unified Audit Trail Probleme bereitet, tangiert dies unseren Trigger nicht, da dies eine eigene asynchrone Transaktion ist.

Wer auf Nummer sicher gehen will, z.B. bei hochkritischen Datenbanken, der kann den Redundanz-Ansatz fahren.

Stufe 1:

- Immer ins Unified Audit Trail umleiten

- immer ins Alert.log schreiben. Standardcode+Exception Handler

Stufe 2:

- Immer in die Triggertabelle schreiben

- Immer ins Unified Audit Trail umleiten

- immer ins Alert.log schreiben. Standardcode+Exception Handler

Zyklische Konsistenzcheck's zwischen allen 2 oder 3 Datenbasen lassen Manipulationen der Auditdaten

recht einfach erkennen. Der Angreifer muss sich schon auskennen, und wenn nicht, kann ihm dies zum Verhängnis werden.

Falls die Redundanz der Auditdaten in der Triggertabelle gewählt wurde, ist ein Löschen dieser Daten relativ zum erfolgreichen Transport + relativ zum erfolgreichen Konsistenzcheck notwendig. Ein simples Truncate ist nicht hinreichend.

Fazit mit Kommentar :

Da die wenigsten Firmen direkt auf Multitenant gehen werden, ist das Unified Auditing skeptisch zu betrachten.

Die Umsetzung von Unified Auditing wurde halbherzig durchgeführt. Kommerzielle Interessen von Oracle (Audit Vault ) und mutmaßliche Langzeitinteressen ( 35 Jahre+) von US-Agencies liest man regelrecht aus der Umsetzung des Unified Auditing heraus. Die partielle Ausklammerung von z.B. 'sys as sysdba' aus diversen Auditfunktionalitäten ausgenommen sys operations spricht Bände. Einen 'sys as sysdba' sollte es nicht geben!

Zudem drängt sich dem Autor die typische Situation heutiger Projektabwicklungen auf, die im Fall Unified Auditing ursprünglich wohl die Ablösung des klassischen Auditing zum Ziel hatte.

Die fehlenden Querverbindungen in der Nutzung beider Mechanismen auf rein funktionaler Ebene bestätigen dies.

Dann wurde wahrscheinlich irgendwann auf die Vereinheitlichung der Audittabellen reduziert und damit man es besser verkaufen kann wurden Audit Policies angedacht und in einer ersten Version bereitgestellt.

Dann hat es wohl mit der Performance Probleme gegeben. Stichworte : Parser und Write Overhead.

Die Idee ein Caching bei Auditdatensätzen einzuführen stellt sich aus Sicht des Autors als ein letzter Rettungsring dar.

Dieser Rettungsring wird, Glück muss man haben, auch noch als Performancebooster verkauft. In-Memory war eben in!

Zum Schluß hat wahrscheinlich irgendein Manager festgelegt das Oracle 12c per Default im Mixed Mode läuft.

Eine sinnvolle Entscheidung!

p.s. Wenn Oracle bei aller Kritik, den einen oder anderen Vorschlag für sein Auditing adaptieren will und soetwas wie eine Anerkennung ausdrücken wollte, dann sei auf den erwähnten Sportwagen verwiesen. 1:18 wäre schon ok!

Innentäter (update 29.03.2015)

Anlaß sind die Meldungen über Kreditanträge der Firma Kreditech, welche im Netz kursieren würden.

Die Firma selbst behauptet, es sei kein Zugang von außen auf die Daten möglich und nie möglich gewesen.

Daraus folgt nach reiflicher Überlegung: Es kann sich nur um Innentäter handeln.

Über ein Caching System seien die Daten abgezogen worden. Gut möglich.

http://www.heise.de/security/meldung/Kreditantraege-von-Kreditech-kursieren-im-Netz-2584198.html

Nach Schätzungen werden 80-90% aller Angriffe auf Daten von Innentätern durchgeführt.

Zwei Themenblöcke ergeben sich hieraus aus Sicht der Data Security :

A.) Wie geht man mit Mitarbeitern um und wie schätzt man seine Kollegen ein ?

B.) Wurden uns mit In Memory Datenbanken und Megadatenbanksystemen mit zigfach verschachelten Cachingsystemen permanente Security Leaks verkauft ?

Themenblock A wurde schon vielen bekannten Experten behandelt. Die Meinung des Autors ist sehr dezidiert.

Vertrauen ist gut, Kontrolle ist besser. Die meisten Mitarbeiter sind anständig bis maximal ein wenig neugierig.

Der Rest ist faktisch kriminell.

Entscheidend ist allerdings, wie schnell heutzutage ein harmloser Mitarbeiter zum Kriminellen werden kann.

Wie ein Bit kippt, kippen heutzutage Mitarbeiter aus den unterschiedlichsten Motiven innerhalb eines Synapsensprungs.

Der Begriff des 'Schläfers', dem selbst nicht bewußt ist, das er ein 'Schläfer' ist, drängt sich dem Autor auf.

Die Gründe hierfür sind vielfältig.

Ersteinmal wird es vielen Mitarbeitern wirklich leicht gemacht Vertrauen im Hinblick auf Daten zu missbrauchen.

Hinzu kommen Egoismus, Geltungsdrang, Streben nach Anerkennung und all dies, das ist entscheidend, ohne irgendein Limit!

Je nach Charakter intelligent verdeckt bis hin zum Koch'schen Paradigma.

Dies ist ein gesellschaftliches Problem, welches eng mit unserer politischen und wirtschaftlichen Ordnung zusammenhängt.

Interessant ist die Falschbild vieler Innentäter bezgl. Entdeckung und deren Folgen. Überschätzung der eigenen Bedeutung und die Negierung altbekannter Unternehmensregeln kommen hinzu. Einige Unternehmen sind schon Konkurs gegangen, weil sie sich von Mitarbeitern getrennt haben, die gegen Unternehmensgrundsätze verstoßen haben.

Der Rausschmiss erfolgt bei rein persönlichen Bereicherungen praktisch immer.

Ein subjektives Resumee :

Zusammenfassend und stark vereinfacht wird nicht nur in Deutschland ein Volk von Superegoisten herangezüchtet, die jeweils, das ist der Unterschied, auf ihren Einsatz warten.

Das ist leider eine schöne Vorlage für Innenminister und ihre Geheimdienste.

Wie geht man nun mit den Mitarbeitern um ?

Da seltsamerweise sensible Daten häufig in Brot und Butter Datenbanken zu finden sind, helfen psychologische Tricks nichts, solange die Trennung der Daten zugriffstechnisch und physisch nicht erfolgt ist.

Konkret könnte man bei unverfänglichen Daten, die separiert abgelegt werden, ( eigene Instanz/DB/...) den Begriff Vertrauen partiell wieder einführen.

Viele Firmen stellen sich hier in ihrer Art der Datenhaltung allerdings selbst ein Bein bzw. gehen mit ihren Daten so um wie z.B. ein Bastler mit Abstellplatz in seiner Garage. Teile und herrsche ist somit der zweite altbekannte Spruch, der dringenst Anwendung finden sollte.Solange dies nicht umgesetzt wird, bleibt leider nur der Generalverdacht.

Das dies ein unmöglicher Zustand ist, wird jeder Einsehen, der die Nähe zur Argumentation von Innenministerien und Geheimdiensten erkennt, die uns alle generell unter Verdacht stellen und uns Tag und Nacht überwachen bzw. ausspionieren.

Bringt man Mitarbeiter nicht in Versuchung, kann man ihnen eher vertrauen. Ein überschaubarer Kreis von Mitarbeitern darf mit kritischen Daten umgehen wobei hier die vollständige Zugriffskontrolle z.B. via Logging in dem Pflichtenheft stehen sollte.

Themenblock B behandelt die Gefahr von gigantischen Cachingsystemem ( z.B. SGA von Oracle ) und In Memory Datenbanken allgemein.

Nein, der Autor glaubt nicht, das diese Techniken nur entwickelt wurden, um mehr oder minder intelligenten Database Security Maßnahmen auszutricksen. Dies natürlich unter dem Deckmantel der Performance.

Auch glaubt der Autor nicht, das ein ominöser Masterplan den Big Data Hype als Resteverwertung der Geheimdienstauswertungen in der zivilen Wirtschaft implementiert hat, um den Bedarf an Auswertungen bis runter auf eine Person im Zeitfenster Samstags 12:00- 13:15 überhaupt erst zu wecken. Obwohl, so ganz auschließen kann man es auch nicht;-)

Interessant ist, das bei nüchterner Betrachung von vielen Big Data Auswertungen wieder der Faktor Neugierde auftaucht.

Da wird ausgwertet, was das Zeug hält. Ob es der eigenen Firma einen Nutzen bringt, sei mitunter dahingestellt.

Das auch hier zwischen Neugierde und krimineller Enegie nur Nuancen liegen, dürfte jeder schon selbst an sich beobachtet haben.

Wie schon im Themenblock oben, empfielt der Autor wieder die Trennung der Daten, nicht nur logisch sondern physisch.

Eigene Oracle Instanzen oder besser physikalisch separate MS SQL Datenbanken mit kritischen Daten und andere Instanzen ( z.B.NO SQL ) für weniger kritische Daten.

Je kritischer die Daten, umso mehr Aufwand sollte betrieben werden um die direkte Anbindung an Internet und Intranet zu vermeiden.

Eigenentwickelte sichere Cachingsysteme zur vollständigen Kontrolle sind ein Ansatz wenn es denn ohne Intranet und Internet nicht geht.

Nun wird es richtig technisch.

Performance in Datenbanken kann je nach Paranoiafaktor als trojanisches Pferd angesehen werden.

Caching von SQL Statements, Zugriffsplänen, deren Resultsets usw. und von In Memory Datenbanken ganz zu schweigen.

Performance Monitoring, Debugging von Datenbankanwendungen, Betriebssystemroutinen, usw.,- all das sind sind potentielle Angriffe auf kritische Daten die in irgendwelchen Speicherbausteinen ihr Dasein mehr oder minder lang fristen.

Für Non In Memory Datenbanken muss die Entscheidung zwischen Security oder Performance als führendes Ziel fallen.

Maßnahmen wie sich selbstzerstörende PLSQL Routinen wurden in einem Artikel auf dieser Seite beschrieben. Flushing weiterer Cachingsbereiche ist nicht trivial, bezogen auf die Verweildauer der Daten in Cachingsystemen umsetzbar. Forcieren von diversen Algorithmen wie LRU, Garbage Collection usw. mit eingehergehendem Sizing der jeweiligen Memory Bereiche stellen die klassische Performance Arbeit praktisch auf den Kopf, bringen jedoch einen deutlichen Schutz zumindest was die Wahrscheinlichkeit von Angriffen angeht.

Bei richtigen In Memory Datenbanken sieht es dagegen finster aus. Hier fallen dem Autor erstmal systemnahe Memory Schutz und Monitoring Funktionen ein. Spezielle Linux Varianten( open source) könnten dies umsetzen.

Weiterhin ist eine automatisierte physikalische Umschichtung von kritischen Daten per Algorithmus ein Themengebiet, das den Autor schon einige Zeit beschäftigt. Kein DBA, kein Admin, kein Wartungstechniker von SAN Systemen weiss genau, wo die kritischen Daten nun konkret liegen.Wenn man gar einen Pool von Datenbanken unterschiedlicher Hersteller definiert und z.B. ein JDBC Gateway besitzt, findet der Begriff Cloud in diesem Kontext eine treffendere Anwendung als bislang üblich.

Ganz allgemein kann die Abkehr vom überbordenden Monitoring ( Performance) hin zum modernen Logging bei vielen isolierten kritischen Datenbanken helfen, solange keine sicheren Betriebssysteme bezogen auf Memory Angriffe existieren.

Zum Schluß sei noch bemerkt, das der Autor die persönliche Bewaffnung in einer mitunter nicht ungefährlichen Welt aus Prinzip ablehnt.Bezogen auf den Datenschutz gilt genau das Gegenteil!

Über die Sinnhaftigkeit von Regelauswertungen für einzelne Datenbankstatments

Datenbankstatements werden regelbasiert überwacht und darauf basierende Events an ein SIEM weitergeleitet.

Die einfachste Lösung wäre theoretisch alle Datenbankstatements via Event an ein SIEM weiterzuleiten.

Bei Applikationsmonitoring in Datenbanken können allerdings schon mal einige Milliarden Events für 10-20 Datenbankstatements

in wenigen Wochen zusammenkommen. Wahrscheinlich kein so guter Ansatz.

Die grundsätzliche Unterscheidung von kritischen und nicht kritischen Datenbankstatements scheint ersteinmal sinnvoll.

Die Einstufung der Datenbankevents als Folge einer Einschätzung des jeweiligen Datenbankstatements auf seine Gefährlichkeit hin, ist eine Kernaufgabe von DAM Tools.

Für diese Einstufung sind allerdings Informationen notwendig. Diese vom DAM Tool bereitgestellten Informationen kann man Regelattribute nennen. Beispiele : STATEMENT, OBJECT (tabelle , ...), OSUSER, DBUSER, APPLIKATION, IP, TIMESTAMP, ...

Die Einstufungen der Events sind abhängig von der Kritikalität und erfolgen üblicherweise in Stufen wie z.B. 'info - high', manchmal auch 'critical'. Wichtig ist das dies auf Basis eines einzelnen Statements erfolgt. Die Behandlung der DAM Events erfolgen auf DAM Seite entweder vor oder nach der Ausführung des Datenbankstatements. Konkret kann ein spezielles DAM Tool einen Abbruch der Datenbanksession mit z.B. 'TERMINATE SESSION' bewirken, bevor das Statement ausgeführt wird.

Ein anderes DAM Tool kann Statements blocken, bevor diese ausgeführt werden.

Die weitere Behandlung bzw. Verarbeitung der Events wird sinnvollerweise in ein SIEM verlagert.